(Traducción, libre, de un artículo original por Eric Price que me parece interesante hacer llegar a la comunidad hispanohablante)

Una eterna duda para los académicos: ¿cómo es de exacto el proceso de revisión por pares y la subsecuente aceptación o rechazo de artículos en congresos científicos? Conseguir publicar en los mejores congresos es de enorme importancia para nuestra carrera [NdT: como sabéis, en España por desgracia ciñéndose a los criterios ANECA no es así, aunque haya congresos más selectivos que muchas revistas indexadas], sin embargo, todos hemos tenido artículos rechazados que creemos que deberían haber entrado, p.ej. tuve un trabajo que fue rechazado tres veces, antes de ser aceptado en SODA… donde ganó el premio al mejor student paper.

Tras un rechazo, nos consolamos pensando que el proceso de revisión es arbitrario; sin embargo, tomamos las aceptaciones como la confirmación de que nuestros trabajos son muy buenos. Así que… ¿cuánto hay realmente de aleatorio en el proceso de revisión? Los organizadores de NIPS decidieron averiguarlo.

El «experimento NIPS»

El experimento de consistencia NIPS ha sido un increíble movimiento lleno de valor por parte de los organizadores de este año destinado a cuantificar la aleatoriedad del proceso de revisión. Dividieron el comité del programa en dos, formando realmente dos comités independientes. La mayoría de trabajos enviados fueron revisados por un único comité, pero el 10% (166) se revisaron por ambos comités. Con esto podrían observar cómo de consistentes fueron los dos comités a la hora de decidir qué papers aceptar. (Para evitar problemas, para este 10% finalmente decidieron aceptar aquellos que habían sido aceptados en al menos una de las dos partes).

Los resultados han sido publicados esta semana: de los 166 papers, los dos comités discreparon en un 25,9% de ellos (43). Pero este número «25%» es engañoso, ya que a la mayoría de personas a quienes se lo he contado hasta ahora no lo han pillado bien: realmente significa que los dos comités discreparon en más papers que en los que concordaron. Dejadme explicarlo.

Se le dio a cada comité el objetivo de un 22,5% de tasa de aceptación final. Esto implica aceptar entre 37-38 de los 166. Como discreparon en 43 trabajos, esto significa que el primer comité aceptó 21 trabajos que el segundo rechazó, y éste aceptó 22 que el primero rechazó, con 21+22=43 el número de trabajos en que se discrepa. Como cada uno aceptó 37-38 trabajos, significa que discreparon en 21/37 o 22/38 ≈ 57% de la lista final de trabajos aceptados.

Este resultado le ha resultado sorprendente a casi todos con los que he hablado, que esperarían algo como un ~30%, pero no casi el doble. En comparación, el 57% está más cerca de un comité que eligiera 100% al azar, en cuyo caso se hubieran obtenido tasas de discrepancia media del 77,5% sobre los trabajos aceptados:

El modelo de la «puntuación con ruido»

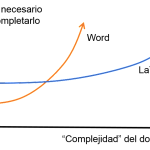

La otra noche, cenando con Jacob Albernethy y hablando del tema, me propuso un modelo de «puntuación con ruido» para intentar modelar qué ocurre con los comités de los congresos basado en su experiencia como area chair. Cada artículo típicamente obtiene 3 revisiones, cada una dando una puntuación numérica entre 0 y 10. El comité usa la nota media como indicador aproximado de la calidad del artículo. Conforme lo entendí, el proceso consiste básicamente en que casi todo lo superior a 6.5 se acepta, casi todo lo inferior a 6 se rechaza y el comité debate sobre principalmente sobre los que están entre esos dos umbrales.

Un modelo simplificado sería así. Cada artículo tiene una puntuación «verdadera» v, muestra extraída de una distribución de probabilidad que modela la puntuación «real» que deberían tener todos los trabajos, p.ej. una distribución normal de media \(v_{media}\) y varianza \(\sigma^2_{between}\). Por otro lado tenemos la puntuación que le da cada revisor a un trabajo, que se podría modelar como otra normal de media la nota «real» v, más una componente aleatoria, p.ej. \(N(v, \sigma^2_{within})\).

De esta forma, el número de papers en que los dos comités discrepan (de media) queda como una función del ratio \(\frac{\sigma_{between}}{\sigma_{within}}\). Hemos encontrado que el experimento NIPS concuerda con este modelo si tomamos que el «ruido» (desviación estándar) de los revisores individuales es entre 1 y 4 veces superior a la de las puntuaciones «reales» (o «justas») que debieran tener.

Una ventaja de este modelo es que no es necesario partir los comités en dos: sería suficiente con que cada congreso midiera las varianzas \(\sigma_{between}\) y \(\sigma_{within}\) para tener una idea de cuánto está afectando la aleatoriedad a la aceptación de trabajos en cada congreso [NdT: ¡asumiendo que se siga validando que este modelo tan sencillo es válido! ;-)].

(Ver artículo original por Eric Price)