Investigadores de la Universidad de Zurich llevan tres años desarrollando algo que tiene toda la pinta de ir camino de revolucionar el mundo de la robótica y los drones. Se trata de un modelo totalmente revolucionario de cámara de visión artificial, que rompe que la tradición de casi un siglo de registrar el movimiento fotograma a fotograma. En lugar de eso, en las nuevas cámaras inspiradas por el funcionamiento de las retinas biológicas cada píxel transmite los cambios que detecta de manera independiente.

En principio, todo son ventajas en comparación con las cámaras tradicionales: un enorme margen dinámico (120 dB!), enorme resolución temporal (del orden de microsegundos en comparación con milisegundos de las tradicionales), reducido consumo (mW), no sufren de blurring (imagen borrosa) en movimientos bruscos, y un largo etcétera. ¿El único problema? Nadie había fabricado antes nada parecido, y el software y los algoritmos de postprocesado están aún en pleno desarrollo. Pero como mostraremos abajo, por fin en 2016 y en lo que va de 2017 se empiezan a ver resultados donde superan a algoritmos basados en cámaras tradicionales.

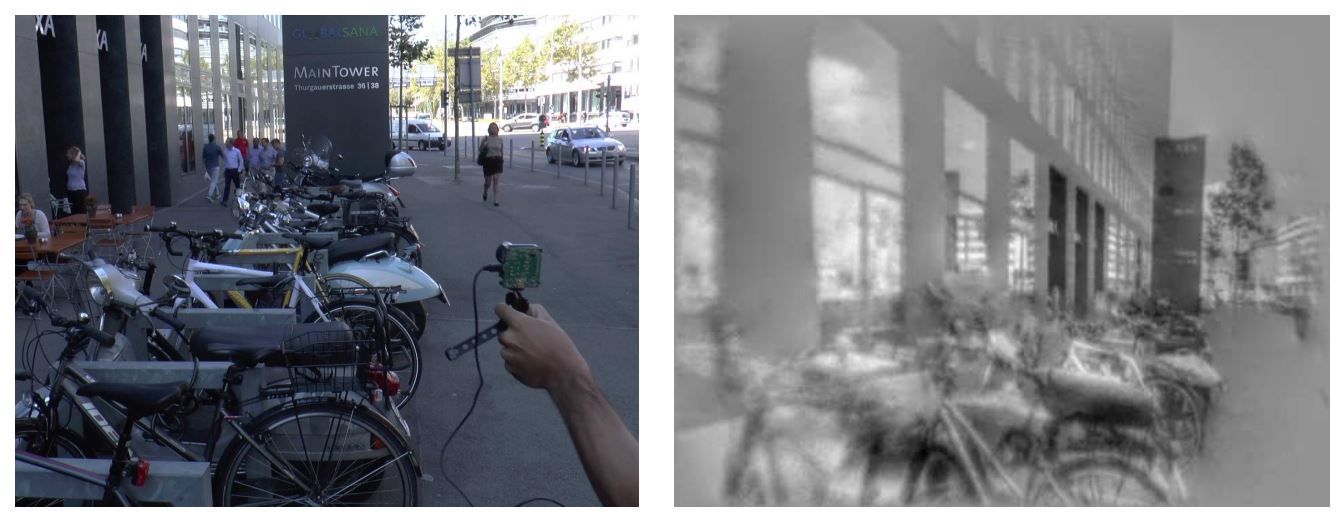

La mejor forma de entender la enorme diferencia entre una cámara tradicional y el nuevo sensor de visión dinámica (Dynamic Vision Sensor, DVS) es viendo cómo ve el mundo. Básicamente, sólo se activan (y se transmiten a la CPU) los píxeles que cambian en cada instante de tiempo. Es así de sencillo… y así de complejo procesar esa información. El siguiente vídeo lo explica muy bien:

El verano de 2016 ya empezaron a publicar algunos resultados en la línea de intentar reconstruir el movimiento de las cámaras en 3D, aunque aún lejos de lo que se podía conseguir con cámaras tradicionales:

Pero el último trabajo, recientemente aceptado para publicación en [1], muestra espectaculares resultados de la aplicación de este tipo de cámaras a lo que se llama «odometría visual», es decir, que un robot móvil o dron sea capaz de «sentir» su propio movimiento a partir únicamente de lo que ve con cámaras. El siguiente vídeo muestra los resultados:

Este es uno de los problemas más difíciles de resolver con cámaras convencionales de manera lo suficientemente robusta como para dejar a un dron o un vehículo autónomo a merced de dicho sensor. De hecho, todos los coches autónomos actuales requieren costosos sistemas LiDAR precisamente por esto.

Si las cámaras de visión dinámica siguen avanzando a este ritmo, es muy posible que sean los ojos de los coches y drones del futuro.

Para leer más:

- [1] Henri Rebecq, Timo Horstschaefer, Guillermo Gallego, Davide Scaramuzza, «EVO: A Geometric Approach to Event-based 6-DOF Parallel Tracking and Mapping in Real-time,» IEEE Robotics and Automation Letters (RA-L), 2016.

- [2] Presentación/tutorial.